Dans mon dernier article je vous ai présenté ce qu'était la DeAI (IA décentralisée) dans un cadre crypto. Aujourd'hui je reviens sur une synthèse de l’étude intitulée "AI-Based Crypto Tokens : The Illusion of Decentralized AI ?". Publiée il y a quelques mois (mi-2025) cette étude critique explore la viabilité, les architectures, et les limites des tokens crypto liés à l’IA, dans une optique d’évaluer leur réelle contribution à la décentralisation. Histoire d'aller plus loin que les simples promesses.

Contexte général et enjeux

L’étude démarre en soulignant que la convergence entre blockchain et IA a donné naissance à une nouvelle catégorie de crypto-actifs, désignés par le terme “tokens IA”. Ces tokens visent à soutenir des plateformes décentralisées pour l’entraînement, le partage et la commercialisation de modèles IA. Et cela dans une optique de rebattre les cartes du pouvoir technologique, souvent concentré entre des mains de géants du cloud ou de grandes firmes.

Cependant, malgré l’enthousiasme, un doute persiste : la majorité de ces projets, une fois passé leur discours sur la décentralisation, restent en réalité confinés à des architectures hybrides où une grande partie des calculs et de l’infrastructure restent hors blockchain, concentrés autour de serveurs centralisés ou semi-centralisés. La problématique centrale réside donc dans la capacité de ces initiatives à réellement décentraliser la gouvernance, mais aussi la propriété des modèles et la gestion des données.

Caractéristiques technologiques des tokens IA

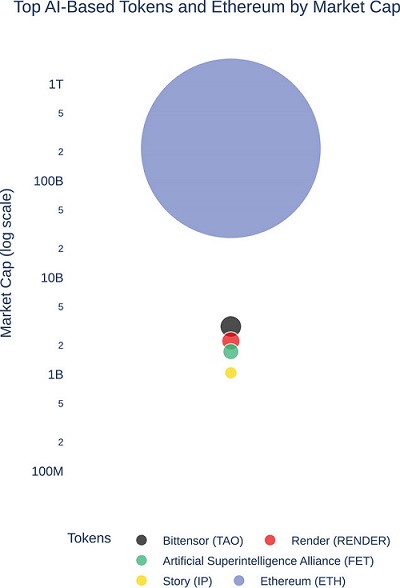

L’étude analyse plusieurs projets phares, tels que SingularityNET (AGIX), Ocean Protocol, Fetch.ai (FET), Bittensor (TAO) ou encore Render (RNDR), pour en décrire l’architecture, l’utilité des tokens, ainsi que le mécanisme de consensus.

Architecture et fonctionnement

Majorité hors-chain : la nature "computationnelle" lourde de l’IA pousse la plupart des plateformes à délocaliser le traitement hors blockchain. Le rôle de la blockchain se limite souvent à la gestion des transactions, à la gouvernance et parfois à l’enregistrement de métadonnées ou la mise en escrow pour les modèles ou datasets.

Preuve de qualité et verifiabilité : des mécanismes comme zk-SNARKs sont en développement, mais restent peu déployés à grande échelle. La vérification intégrale du résultat d’un modèle IA sur la blockchain reste un défi, notamment pour des modèles complexes.

Consensus et participation : la majorité des projets s’appuient encore sur des mécanismes PoS, à l’exception de certains utilisant des modèles hybrides ou des Proof of Useful Work (PoUW) pour aligner l’économie de la plateforme avec l’utilité réelle des modèles.

Limitations techniques

- Scalabilité : la capacité de traitement des réseaux blockchain pour l’IA reste limitée. La majorité des modèles lourds (ex. Large Language Models) ne peuvent pas encore tourner réellement en onchain de façon robuste.

- Interoperabilité : la fragmentation entre plusieurs chaînes et projets rend difficile la construction d’un écosystème fluide où modèles, datasets, et tokens circulent aisément.

- Qualité et vérification : la validation des résultats d’IA reste limitée, car il n’existe pas encore de mécanismes universels pour assurer la performance, la conformité, et la sécurité des modèles déployés dans ces systèmes décentralisés.

Décentralisation des tokens IA : limitations et illusions

Les résultats montrent que beaucoup de projets conservent une forte centralisation dans leur gouvernance, leur infrastructure, ou leur développement. La majorité des tokens IA sont décrits comme des “illusion de décentralisation”, où le contrôle stratégique demeure concentré, tandis que la promesse d’un écosystème totalement autonome et gouverné par la communauté reste largement théorique.

De plus, la majorité de ces tokens ne parviennent pas à démontrer une adoption réellement significative. Soumis à une forte spéculation, leur utilité est souvent déconnectée de l’usage concret. La tendance est donc à une survalorisation financière plus qu’à une innovation technologique disruptive.

Analyse des risques et obstacles

- Répartition centralisée du contrôle : des acteurs clés maintiennent encore leur pouvoir d’influence, ce qui limite la véritable autonomie des modèles et des données.

- Problèmes de scalabilité : la puissance de traitement pour l’intelligence artificielle doit encore s’aligner avec les mécanismes distribués, l’interopérabilité et la vérification en blockchain restant insatisfaisantes.

- Fiabilité et qualité : la difficulté de garantir la qualité et la sécurité des modèles déployés est encore une barrière majeure, puisque la plupart des solutions reposent sur des mécanismes d’incitation, plutôt que sur une vérification objective et immédiate des outputs.

- Mécanismes d’incitation : la décentralisation réelle exige des modèles économiques robustes et équilibrés, ce qui n’est pas encore totalement réalisé dans la majorité des projets.

Évolutions et perspectives pour le futur

Malgré ces limitations, plusieurs innovations sont en cours de développement, visant à surmonter ces barrières. Les principales pistes mentionnées dans l’étude sont :

- Preuves à divulgation nulle de connaissance (zk) pour l’IA : c'est à dire la possibilité de prouver la véracité d’un résultat IA sans en révéler les détails, permettant une vérification efficace et confidentielle.

- Blockchain spécifique à l’IA : la naissance de blockchains spécialisées conçues pour l’IA, avec support intégré pour GPU, sharding par tâche, ou mécanismes de Proof of Useful Work (PoUW).

- Architectures modulaires : la transition vers des architectures décomposant fonctionnellement la blockchain en couches de consensus, exécution, et stockage, ainsi que des solutions inter-chaînes (interopérabilité).

- L'apprentissage fédéré (Federated learning) : la collaboration décentralisée pour l’entraînement de modèles sans échange de données sensibles, avec enregistrement transparent des contributions. Un peu comme le projet Sapien.

- Incentive schemes avancés : l’utilisation de mécanismes comme la récompense par la contribution de qualité, le staking d’actifs, ou la tokenomics hybride pour attirer et retenir les contributeurs.

Enjeux réglementaires et éthiques

L’étude souligne aussi l’importance d’un cadre réglementaire précis. La traçabilité, la gouvernance démocratique et la conformité aux réglementations (RGPD, AML, KYC) ne sont pas encore équitablement intégrées. La prolifération de modèles décentralisés pose des questions sur la responsabilité légale en cas de défaillance ou de contenu problématique. Le déploiement massif d’IA décentralisée soulève bien des enjeux cruciaux en termes de sécurité, de responsabilité et de conformité.

L’analyse révèle que si l’écosystème des tokens IA possède un potentiel stratégique énorme, il est encore fortement entravé par des limitations techniques, de scalabilité et de vérifiabilité. La promesse d’une décentralisation véritable, sûre et utile reste en grande partie à réaliser. L’avenir dépendra de capacités à intégrer des mécanismes de preuve avancés, architectures modulaires, et modèles de gouvernance participative, tout en naviguant dans un cadre réglementaire en constante évolution.

Le secteur de la décentralisation des tokens IA demeure donc à la croisée des chemins, avec une promesse d’innovation majeure, mais une réalisation encore en devenir.